|

|

1 year ago | |

|---|---|---|

| 05_1543348250-660x320.jpg | 1 year ago | |

| LICENSE | 1 year ago | |

| README.md | 1 year ago | |

| acc-unnorm-cocowm-11epochs.png | 1 year ago | |

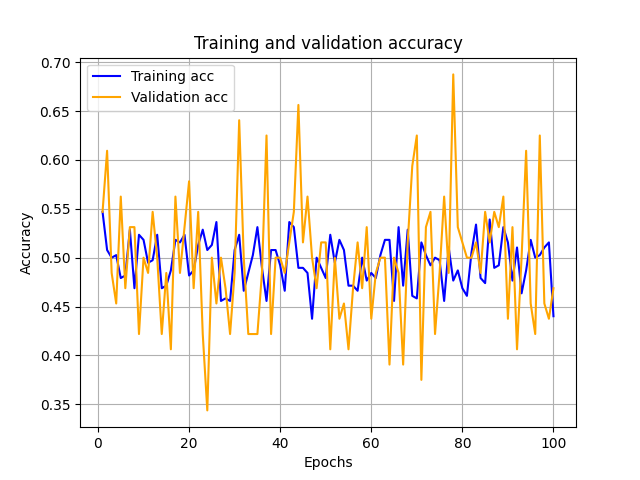

| acc_whitewm_norm100epochs.png | 1 year ago | |

| keras-2.15.0-python-3.11.5.png | 1 year ago | |

| mcc.JPG | 1 year ago | |

| mtx.JPG | 1 year ago | |

| pretrainedklaas.ipynb | 1 year ago | |

| Снимок экрана_2024-03-24_09-48-17.png | 1 year ago |

README.md

keras == 2.15.0, python == 3.11.5.

Оптимизатор Adam: достаточно упомянуть, что это более сложный оптимизатор, в котором скорость обучения задается адаптивно. Кроме того, он намного менее чувствителен к масштабу параметров — настолько нечувствителен, что мы можем снова воспользоваться исходным (ненормализованным) входным сигналом t_u и даже увеличить скорость обучения до 1e-1, и Adam даже глазом не моргнет PyTorch. Освещая глубокое обучение (стр 179,186)

Sources

- Binary-classification-for-DCTandSVD-watermarks

- my-check-for-a-result-from-an-ai-article/pretrainedstegaanalyzator

- Метрики качества моделей бинарной классификации

- Classification metrics based on True/False positives & negatives

- 8 показателей эффективности классификации

- Корреляция Мэтьюса

- Пережевывая Матрицу Несоответствий — Confusion Matrix

- Оценка качества в задачах классификации и регрессии